Probabilistic End-to-end Noise Correction for Learning with Noisy Labels

スポンサーリンク

論文URL

ポイント

- 分類問題において教師ラベルのアノテーションミスを推定し、ミスを修正したラベルによりモデルを学習するPENCIL(probabilistic end-to-end noise correction in labels)フレームワークを提案

- 数十%の大量のミスラベルが有っても一定の性能を確保している

- アノテーションミスが少ない(と考えられている)データセットに対してPENCILフレームワークを適用した場合、通常の学習方法と比べ最終的な分類モデルの性能に有意差は無い(大きな悪影響を及ぼすことは無い)

PENCILフレームワーク

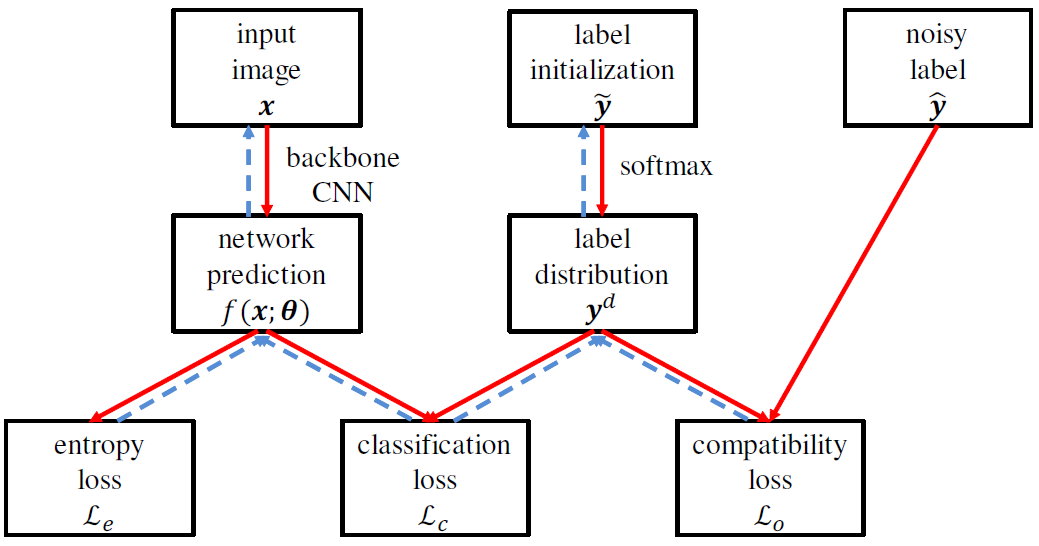

- Fig1の構造で、分類モデル

とアノテーションミス修正後教師ラベル

を推定する

- 損失関数

- classification loss

- KL-divergenceでモデルの推論確率と修正後教師ラベルの確率分布を一致させる

- 基準の分布を

にしていることに注意

- 基準の分布を

は、教師ラベル

を用いて以下の式で初期化されている

- 学習が進むと

はone-hot表現ではなく、入力画像のクラス確率分布になる

- compatibility loss

が教師ラベル

から乖離しすぎないように抑制するLoss

- entropy loss

- このLossは推論確率がone-hot表現の時に最小となるため、推論確率がフラットになることを抑制し、特定の1クラスの推論確率にピークが出るように働く

- classification loss

- 学習方法

- 教師ラベルの修正は行わず、Cross Entropy Lossでモデルを学習

- アノテーションミスを学習しすぎないように、学習率を大きく設定し過学習を抑制する

- PENCILフレームワークでモデルと教師ラベルの両方を学習

- このステップも、学習率は大きいままとする

- classification Lossだけを使用し、モデルのみをFine tuning

- 学習率は通常通りステップ状に小さくしていく

- 教師ラベルの修正は行わず、Cross Entropy Lossでモデルを学習

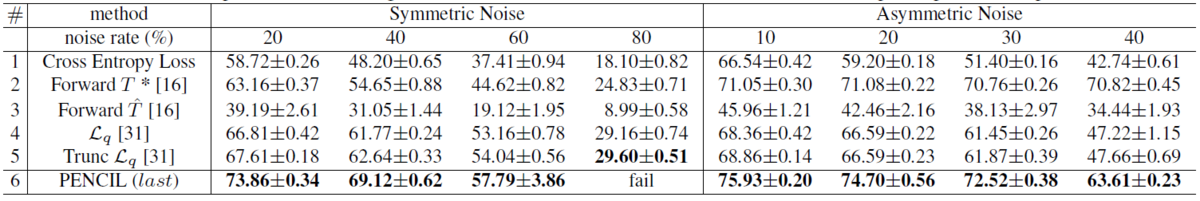

人工的にアノテーションミスを付与したCIFARでの評価結果

- CIFARに以下の2種類のアノテーションミスを付与して評価

- symmetric noise : 確率 r で全クラス一様にミスラベルを付与

- asymmetric noise

- CIFAR-100の場合、隣接クラスと確率 r でラベルを入れ替える

- CIFAR-10の場合、犬⇔猫のように似ているクラス間で、確率 r でラベルを入れ替える

<CIFAR-100の結果>

- Cross Entropyで通常通り学習した結果に比べ、性能低下が有意に抑えられている

- 2行目のForward T*は、真のノイズ遷移行列が既知と言う非現実的な条件のため単純比較はできない

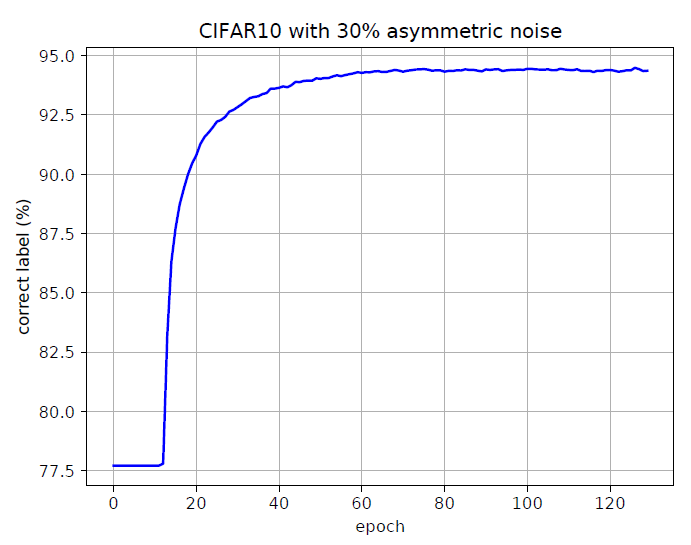

<CIFAR-10の修正後ラベルの正解率>

- CIFAR-10のケースでは上記プロットのいずれのケースも、学習の中盤以降9割前後のラベルが正しいラベルになっている

Clothing1Mでの評価結果

- 約40%のラベルが間違っていると推定されているオンラインショッピング画像データセット

- 一部のデータはアノテーションミスを修正した高精度の教師データとなっている

- 以下の表のPENCILの結果は高精度の教師データを使用していない

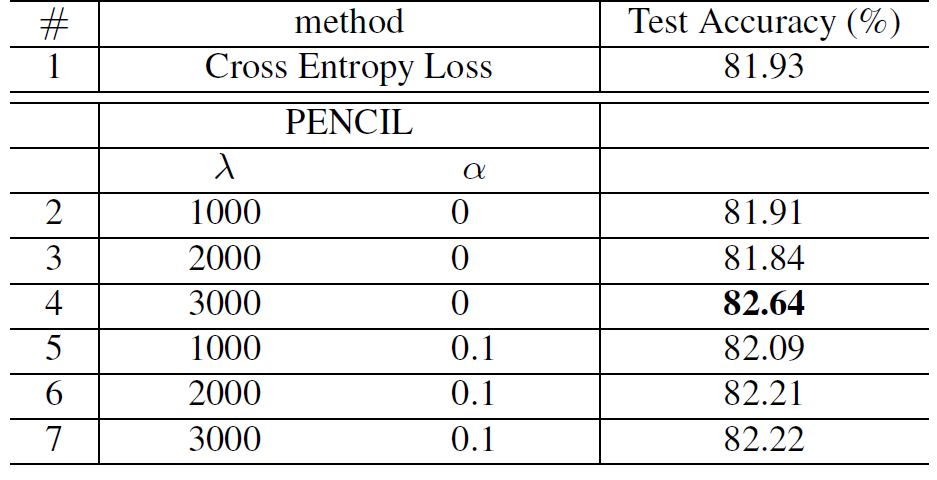

CUB-200での評価結果

- 高精度のアノテーションがされていると考えられる200種の鳥類分類データセット

- ハイパーパラメータλ、α(詳細は論文を参照)に寄らず、Cross Entropy Lossで学習した結果と同等以上の結果が得られている

スポンサーリンク