Probabilistic End-to-end Noise Correction for Learning with Noisy Labels

スポンサーリンク

論文URL

ポイント

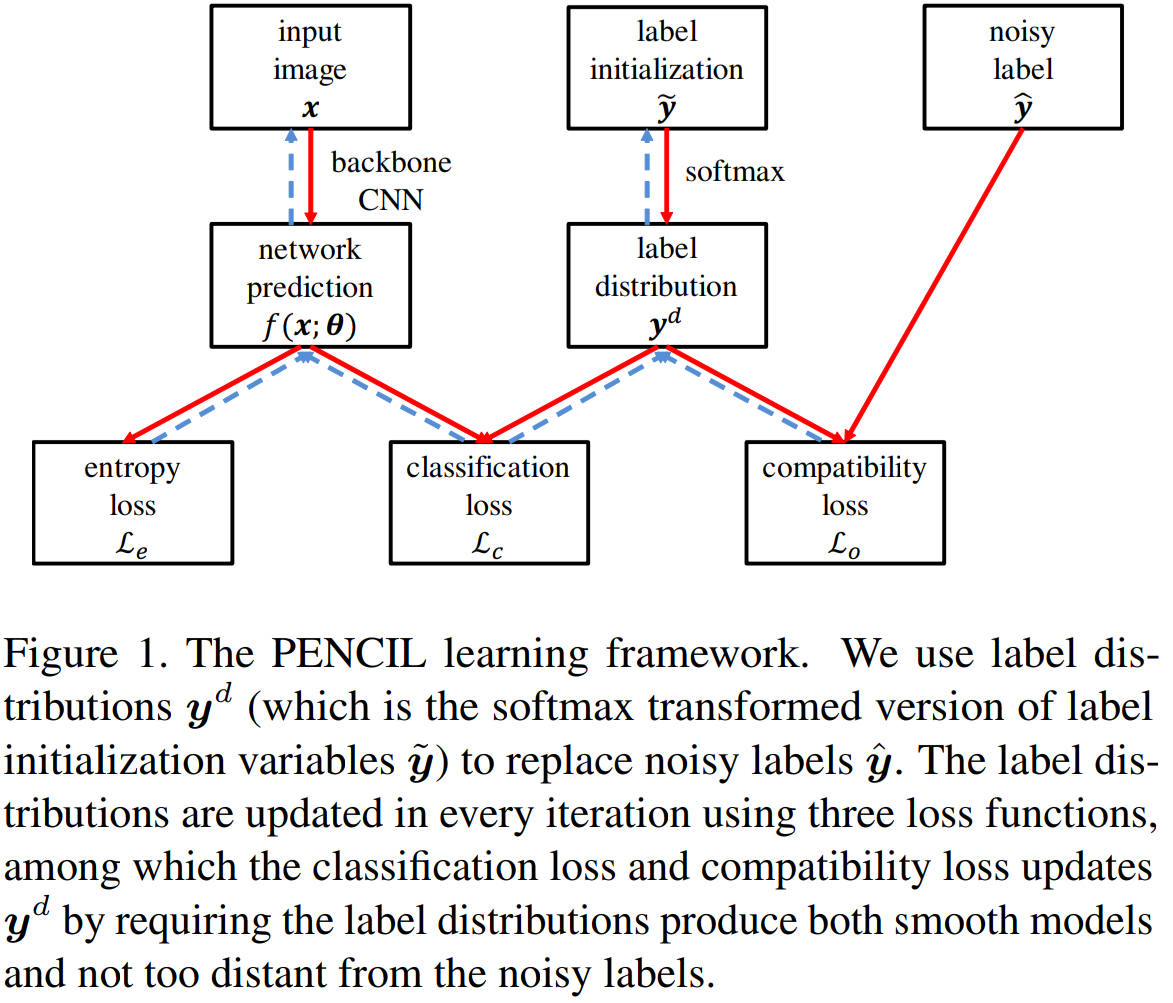

- ラベルのアノテーションミスを推定し、修正したラベルにより分類モデルを学習するPENCIL(probabilistic end-to-end noise correction in labels)フレームワークを提案

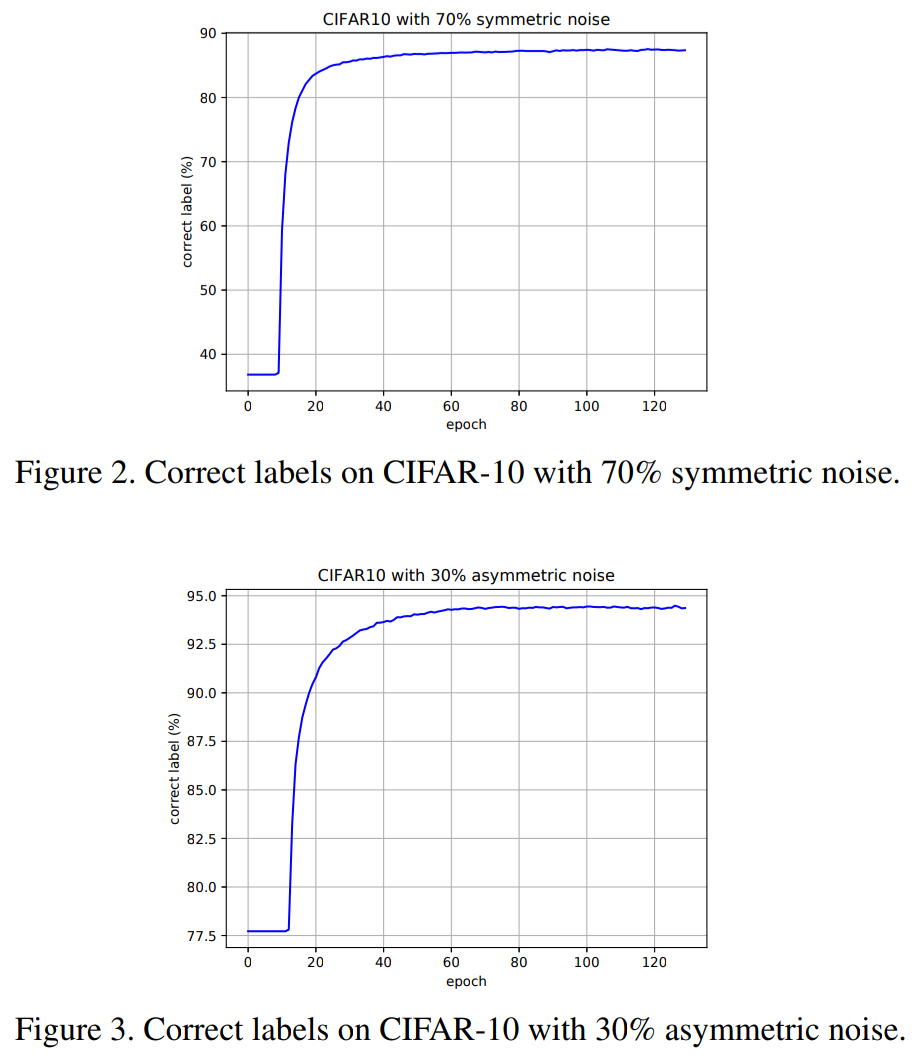

- 数十%の大量のミスラベルが有っても一定の性能を確保している

- 精度の高いラベルが付いたデータセットも不要

- Entropy Loss

- このLossによりone-hot distributionを保てるとのこと

- Classification Loss

- 基準の分布を教師ラベルではなく、推論確率にしている

- Compatibility Loss

- 最初のラベルと修正後のラベルが変わりすぎないように抑制するLoss

- 学習方法

- CUB-200は鳥の分類データセットで高精度のラベルが付いていると考えられている

- ラベルが高精度でもPENCILが悪さをすることはなく、ハイパーパラメータ次第では高精度になることも。

スポンサーリンク