Attentive Feedback Network for Boundary-Aware Salient Object Detection

スポンサーリンク

論文URL

ポイント

- Salient object detection(画像中の注目物体検出)を題材に、精細な物体境界が得られるAFNetを提案

- 以下のモジュールおよび損失関数を導入

- Global Perception Module(GPM)

- Attentive Feedback Module(AFM)

- Boundary Enhanced Loss(BEL)

- 以下のモジュールおよび損失関数を導入

- AFNetではSoTAの結果となっていたが、意図を理解しきれずモデル構造には疑問を感じた

- その一方、BELは境界領域の精度を上げるLossとしてシンプルで有用に感じた

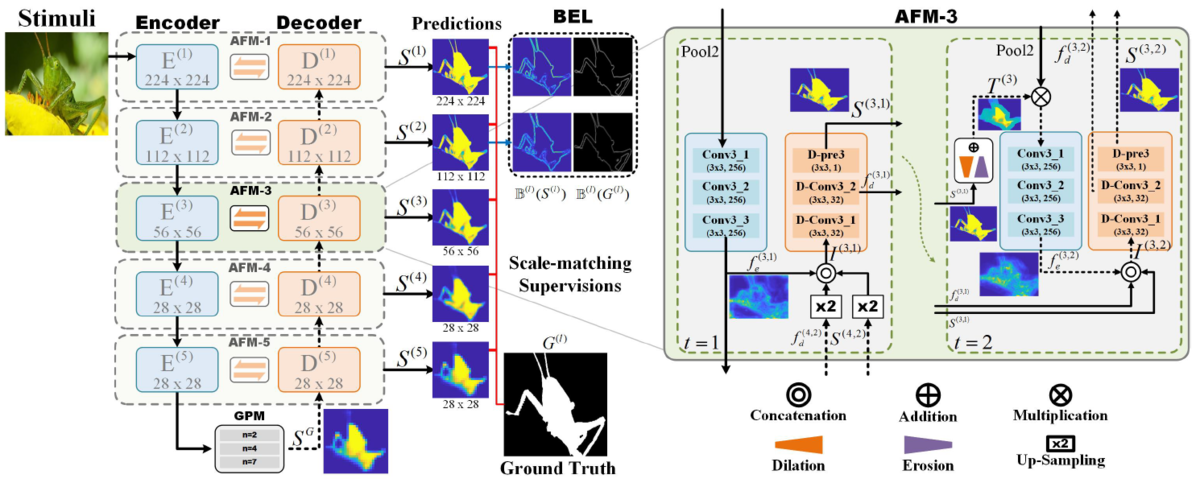

AFNetの概要(Fig1)

- Encoderの直後のGPMで粗いsegmentationマスクを生成し、Decoderでそのマスクを精細化していく

- EncoderとDecoderはスキップコネクションの代わりにAFMで接続される

AFNetに対する疑問点

- GPMでは、Fig2のように入力特徴量テンソルを等分割の区画に分け(Fig2は2x2の4分割の例)、各区画の同一箇所(Fig2の青領域)を畳み込んで、出力特徴量テンソルを得る

- 等分割した区画の同一箇所を畳み込む意図やメリットを理解できなかった

- AFMでは2段階でsegmentationマスクを精細化する

- 1段階目では以下を入力としてsegmentationマスクを計算

- 同一レベルのencoderブロックの出力特徴量テンソル

- 前段のdecorderブロックの出力特徴量テンソル

- 前段のdecorderブロックの出力segmentationマスク

- 2段階目で以下の重みをencoderの特徴量マスクにかけている

- 1段階目のsegmentationマスクから膨張処理画像と収縮処理画像を算出

- 膨張処理画像と収縮処理画像の平均画像を計算(Fig1右側AFM-3内の

)

- 平均画像の画素値は、背景領域がおよそ0、注目物体領域がおよそ1、境界領域はおよそ0.5となる

- この平均画像をencoderにかけてしまうと、境界領域の特徴量が弱まることになるはずで、この演算の意図も理解できなかった

- 論文中でAFMの有無を比較したablation studyは行われているが、シンプルなスキップコネクションとの比較がなされていないため、AFMに本当に効果があるのか疑問を払拭できなかった

- 1段階目では以下を入力としてsegmentationマスクを計算

Boundary Enhanced Loss(BEL)

- 推論マスクと教師マスクのそれぞれの画像で、移動平均フィルタ(=stride 1のaverage pooling)をかけた画像と元画像の差の絶対値を計算

- 物体境界領域が抽出される

- 上記境界抽出画像間のEuclidean LossをBELとする

AFNetの性能

- 赤がTop1、緑がTop2、青がTop3

- AFNetはDUTSの学習データで訓練したモデルを他のデータの評価でも使用している

- 右端のDUTSに対する結果以外は単純に比較できない

- DUTSは最近リリースされた大規模データセットだとの記述があり、データ量の点でAFNetが有利になっている

- 一方、AFNetが十分な汎化性能を持っていると解釈することもできる